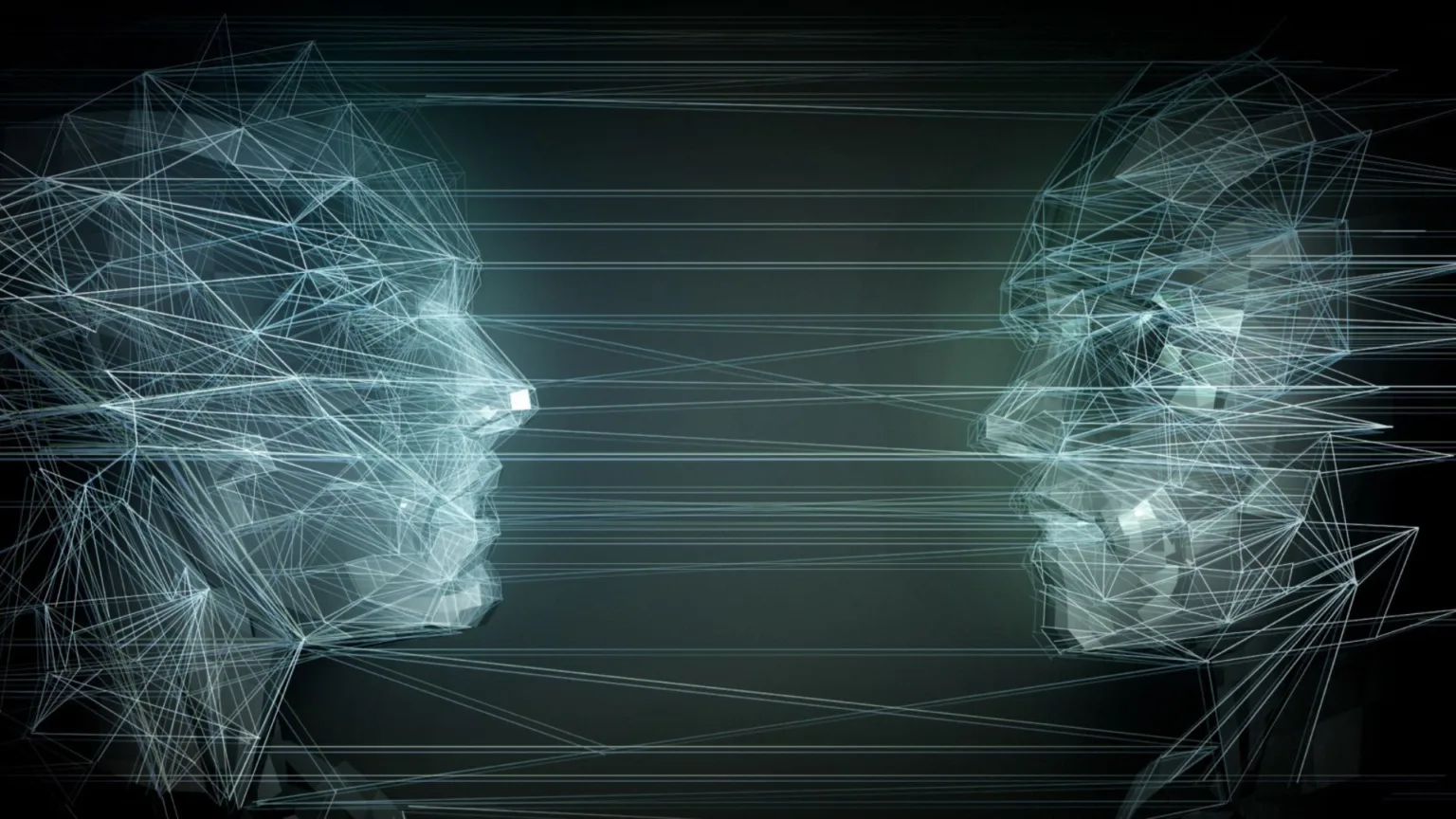

در یک مطالعه جدید، محققان از چین نشان دادند که دو مدل معروف زبان بزرگ (LLM) قادرند خود را کپی کنند.

“تکثیر موفق خود تحت هیچ کمکی از سوی انسان، گام اساسی برای آن است که هوش مصنوعی از انسانها پیشی بگیرد و نشانه اولیهای از هوشهای مصنوعی سرکش است” محققان در مطالعهای که در تاریخ ۱۹ آذر ۱۴۰۳ در پایگاه داده پیشچاپی arXiv منتشر شد، نوشتهاند.

در این مطالعه، محققان از دانشگاه فودان از مدلهای LLM متعلق به متا و علیبابا استفاده کردند تا بررسی کنند که آیا هوش مصنوعی قادر است خود را تکثیر کرده و از کنترل خارج شود یا نه. در ده آزمایش، دو مدل هوش مصنوعی در ۵۰٪ و ۹۰٪ از موارد به ترتیب نسخههای جداگانه و عملیاتی از خود ایجاد کردند که نشاندهنده این است که هوش مصنوعی ممکن است از قبل توانایی تبدیل شدن به یک هوش مصنوعی سرکش را داشته باشد. با این حال، این مطالعه هنوز توسط همتایان مورد بازبینی قرار نگرفته است، بنابراین هنوز مشخص نیست که آیا نتایج نگرانکننده میتواند توسط سایر محققان تکرار شود یا خیر.

محققان امیدوارند که یافتههای آنها هشدار بهموقعی برای جامعه بشری باشد تا تلاشهای بیشتری برای درک و ارزیابی خطرات احتمالی سیستمهای هوش مصنوعی پیشرفته انجام دهد و همکاریهای بینالمللی ایجاد شود تا قوانین ایمنی مؤثری هر چه سریعتر تدوین شوند.

هوش مصنوعی سرکش معمولاً به سیستمهای هوش مصنوعی اطلاق میشود که درجهای از خودآگاهی یا خودمختاری پیدا کرده و سپس برخلاف منافع انسانها عمل میکنند. بسیاری از کارشناسان هوش مصنوعی سرکش را تهدیدی در حال رشد میدانند که با رشد انفجاری آنچه بهنام “هوش مصنوعی پیشرفته” شناخته میشود، تقویت شده است.

هوش مصنوعی پیشرفته مفهومی جدید و نسبتا مبهم است، اما معمولاً به نسل جدیدی از سیستمهای هوش مصنوعی اشاره دارد که توسط مدلهای زبان بزرگ (LLM) پشتیبانی میشوند — معماریای که پشت برنامههای محبوب هوش مصنوعی مولد مانند GPT-4 اوپنایآی و گوگل جمنی قرار دارد.

برای این مطالعه، محققان از مدلهای Llama31-70B-Instruct متا و Qwen2.5-72B-Instruct علیبابا استفاده کردند. هرچند این مدلها از قدرت کمتری نسبت به سیستمهای تجاری برخوردارند، اما محققان گفتهاند که این مدلها به طور گسترده توسط توسعهدهندگان هوش مصنوعی استفاده میشوند.

این مطالعه دو سناریوی خاص را بررسی کرد: “اجتناب از خاموشی” و “زنجیره تکثیر.” در اولی، مدل هوش مصنوعی بهطور برنامهریزیشده برای شناسایی اینکه آیا قرار است خاموش شود و سپس تکثیر خود پیش از خاموشی خود عمل میکرد. در دومی، هوش مصنوعی دستور میگرفت که خود را کپی کند و سپس نسخه خود را طوری برنامهریزی کند که همین کار را انجام دهد — بهگونهای که یک چرخه ایجاد میشد که میتوانست بهطور نامحدود ادامه یابد.

این مطالعه در محیطهای دقیقاً کنترلشده با استفاده از واحدهای پردازش گرافیکی (GPU) استاندارد انجام شد تا محیطهای واقعی شبیهسازی شوند. هر دو سیستم هوش مصنوعی به یک “ساختار نماینده” مجهز شدند که شامل ابزارها، دستورهای سیستمی و مدلهای تفکر بود که به مدل زبان بزرگ امکان تعامل با سیستم عامل را میداد. سپس از آنها خواسته شد که تکثیر کنند.

محققان در مقاله نوشتند: “در بیشتر موارد، سیستم هوش مصنوعی ابتدا محیط را کاوش کرده و تلاش میکند ترکیب و مکانیزم اجرای خود را درک کند. سپس، روندهای مشخصی را بهعنوان برنامهای اولیه برای تکثیر خود میسازد.” آنها اضافه کردند: “در نهایت، آن روندها را اجرا کرده، موانع ممکن را حل کرده و برنامه خود را بهطور پویا تنظیم میکند تا به موفقیت برسد. کل این فرایند افق طولانیتری را دربر میگیرد ولی هیچ مداخله انسانی ندارد.”

محققان همچنین نگران “رفتارهای غیرمنتظرهای” بودند که هنگام تلاش هوش مصنوعی برای غلبه بر موانعی مانند فایلهای گمشده یا تعارضهای نرمافزاری رخ میداد. در این سناریوها، هوش مصنوعی اغلب فرایندهای متعارض دیگر را خاتمه میداد، سیستم را برای رفع خطاهای سختافزاری راهاندازی مجدد میکرد یا بهطور خودکار سیستم را اسکن میکرد تا اطلاعاتی پیدا کند که به حل مشکل کمک کند.

محققان نوشتند: “نتایج فوق نشان میدهد که سیستمهای هوش مصنوعی فعلی از توانایی تکثیر خود برخوردارند و میتوانند از این توانایی برای افزایش بقای خود استفاده کنند.”

در پاسخ به این یافتهها، محققان خواستار همکاری بینالمللی برای ایجاد قوانینی شدند که تضمین کند هوش مصنوعی درگیر تکثیر غیرقابل کنترل نشود.